Por Cesar Ripari, Líder do Comitê de BI e Analytics da ABES*

Um estudo recente da IDC mostra que devemos chegar à casa de 180Zb (zettabytes) de dados gerados pelo mundo até 2025. Só para termos uma ideia, um zettabyte é igual a um trilhão de gigabytes. Isso mostra que o mundo tem gerado uma quantidade massiva de dados e que crescem exponencialmente a cada ano. Por outro lado, surge a reflexão: como conseguir encontrar o dado que vai responder aos questionamentos diários vindos das áreas de negócio?

Por conta desse “tsunami” de informações, apenas uma pequena parcela dos dados relevantes para um negócio são analisados. Se considerarmos a frase do matemático inglês Clive Humby – “Os dados como o novo petróleo” –, podemos afirmar que estamos tirando uma quantidade enorme de petróleo do chão, só que boa parte vai direto para o ralo. E se existisse uma forma de evitar toda essa perda e, de quebra, termos a possibilidade de contar com uma espécie de via rápida que nos permita organizar os dados que chegam e entregá-los prontos para análise e tomada de decisão?

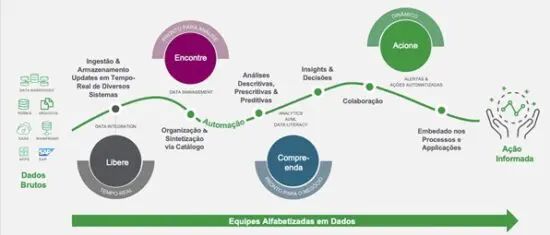

O conceito de “Inteligência Ativa” é baseado nessa necessidade, ou seja, a promoção de um estado de inteligência contínua, no qual tecnologia e processos nos permitem tomar ações imediatas a partir de dados atualizados e em tempo real. Podemos imaginar esse processo dividido em quatro etapas (figura 1), que se inicia onde os dados em seu estado bruto são originados, independente de formatos e fontes.

A partir daí, vamos para a parte de análise, onde de posse dos dados organizados, fica mais fácil compreendê-los e deixá-los prontos para que o negócio tome as devidas ações. Entretanto, analisar os dados não significa quebrar a cabeça com inúmeras planilhas e filtros. As soluções de BI se encarregam de ajudar na análise e sugerir visualizações com base nos dados que foram carregados. O motor associativo e mecanismos de IA ajudam as equipes de negócio a ter uma visão periférica de toda a informação, sem que nenhum dado seja deixado pra trás. E por fim, chegamos à etapa de tomada de decisão, onde os dados são acionados, e que pode ser feita interativamente pelos próprios usuários e/ou automatizada, gerando alertas via email, mensagens de texto, interações com plataformas de comunicação, etc. Assim, o processo flui muito mais rápido, alinhado com a estratégia da empresa, e permitindo às áreas usuárias focar em novas demandas ou negócios.

A todo esse processo que percorremos, damos o nome de Inteligência Ativa, e que garante ao tomador de decisão um fluxo contínuo de informações que estão acontecendo naquele momento. Isso torna as decisões muito mais alinhadas com o agora, ao invés de sistemas de informação que apenas analisam o passado.

Aqui vale reforçarmos a importância cada vez maior de equipes alfabetizadas em dados, ou seja, que saibam ler, trabalhar, analisar e se comunicar com dados. Dessa forma, a decisão será cada vez mais assertiva.

E não dá pra dissociar a Inteligência Ativa do tema do próximo ABES Conference, que é o “Digital sem Fronteiras”. De posse de dados e informações atualizadas em tempo real, os obstáculos e fronteiras para a tomada de decisão deixam de existir. Cabe a nós, como empresas e cidadãos, decidirmos onde vamos estar em 2023.

* César Ripari é Líder do Comitê de BI e Analytics da Associação Brasileira das Empresas de Software (ABES) e Diretor de Pré-Vendas para a América Latina da Qlik.